El modelo de lenguaje grande hace de todo, desde leer la literatura hasta escribir y revisar sus propios artículos, pero hasta ahora tiene un rango de aplicabilidad limitado.

¿Se podría automatizar por completo la ciencia? Un equipo de investigadores en aprendizaje automático lo ha intentado.

‘AI Scientist’, creado por un equipo de la empresa Sakana AI de Tokio y en laboratorios académicos de Canadá y el Reino Unido, realiza el ciclo completo de investigación, desde la lectura de la literatura existente sobre un problema y la formulación de hipótesis para nuevos desarrollos hasta la prueba de soluciones y la redacción de un artículo. AI Scientist incluso realiza parte del trabajo de los revisores pares y evalúa sus propios resultados.

AI Scientist se suma a una serie de esfuerzos para crear agentes de IA que hayan automatizado al menos partes del proceso científico. “Hasta donde yo sé, nadie ha logrado automatizar toda la comunidad científica en un solo sistema”, afirma el cocreador de AI Scientist, Cong Lu, investigador de aprendizaje automático en la Universidad de Columbia Británica en Vancouver, Canadá. Los resultados 1 se publicaron en el servidor de preimpresión de arXiv este mes.

“Es impresionante que hayan hecho esto de principio a fin”, dice Jevin West, un científico social computacional de la Universidad de Washington en Seattle. “Creo que deberíamos estar experimentando con estas ideas, porque podrían tener potencial para ayudar a la ciencia”.

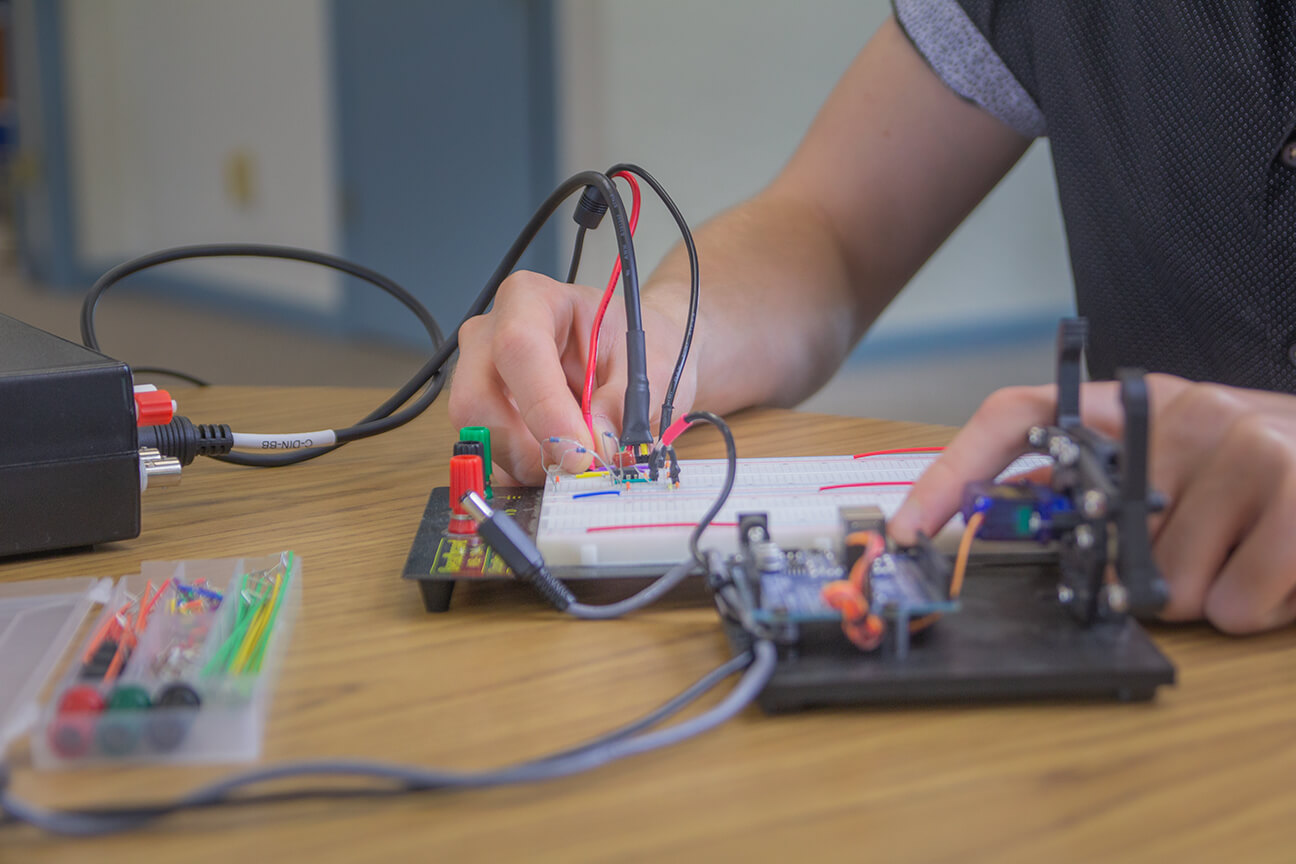

El resultado no es nada del otro mundo hasta ahora, y el sistema solo puede investigar en el campo del aprendizaje automático. En particular, a AI Scientist le falta lo que la mayoría de los científicos considerarían la parte crucial de hacer ciencia: la capacidad de hacer trabajo de laboratorio . “Todavía queda mucho trabajo por hacer desde la IA que formula una hipótesis hasta la implementación de esa hipótesis en un científico robot”, dice Gerbrand Ceder, científico de materiales del Laboratorio Nacional Lawrence Berkeley y de la Universidad de California, Berkeley. Aun así, Ceder añade: “Si miramos hacia el futuro, no tengo ninguna duda de que es hacia donde irá gran parte de la ciencia”.

Experimentos automatizados

AI Scientist se basa en un modelo de lenguaje amplio (LLM). Utilizando un artículo que describe un algoritmo de aprendizaje automático como plantilla, comienza por buscar en la literatura trabajos similares. Luego, el equipo empleó la técnica denominada computación evolutiva, que se inspira en las mutaciones y la selección natural de la evolución darwiniana. Procede por pasos, aplicando pequeños cambios aleatorios a un algoritmo y seleccionando los que proporcionan una mejora en la eficiencia.

Para ello, AI Scientist lleva a cabo sus propios «experimentos» ejecutando los algoritmos y midiendo su rendimiento. Al final, produce un artículo y lo evalúa en una especie de revisión por pares automatizada. Después de «aumentar la literatura» de esta manera, el algoritmo puede comenzar el ciclo nuevamente, basándose en sus propios resultados.

Los autores admiten que los artículos que produjeron los científicos de IA contenían solo avances graduales. Otros investigadores fueron mordaces en sus comentarios en las redes sociales. “Como editor de una revista, probablemente los rechazaría de inmediato. Como revisor, los rechazaría”, dijo un comentarista en el sitio web Hacker News.

West también dice que los autores adoptaron una visión reduccionista de cómo los investigadores aprenden sobre el estado actual de su campo. Gran parte de lo que saben proviene de otras formas de comunicación, como asistir a conferencias o charlar con colegas en la cafetería. “La ciencia es más que una pila de artículos”, dice West. “Puedes tener una conversación de cinco minutos que será mejor que un estudio de cinco horas de la literatura”.

El colega de West, Shahan Memon, está de acuerdo, pero tanto West como Memon elogian a los autores por haber hecho que su código y sus resultados sean completamente abiertos. Esto les ha permitido analizar los resultados de AI Scientist. Han descubierto, por ejemplo, que tiene un «sesgo de popularidad» en la elección de artículos anteriores que enumera como referencias, eludiendo aquellos con un alto número de citas. Memon y West dicen que también están estudiando la posibilidad de medir si las elecciones de AI Scientist fueron las más relevantes.

Tareas repetitivas

Por supuesto, AI Scientist no es el primer intento de automatizar al menos varias partes del trabajo de un investigador: el sueño de automatizar el descubrimiento científico es tan antiguo como la propia inteligencia artificial: se remonta a la década de 1950, dice Tom Hope, un científico informático del Instituto Allen para la IA con sede en Jerusalén. Ya hace una década, por ejemplo, el Automatic Statistician2 era capaz de analizar conjuntos de datos y escribir sus propios artículos. Y Ceder y sus colegas incluso han automatizado parte del trabajo de laboratorio: el «químico robot» que dieron a conocer el año pasado puede sintetizar nuevos materiales y experimentar con ellos3.

Hope dice que los actuales LLM “no son capaces de formular nuevas y útiles direcciones científicas más allá de las combinaciones superficiales básicas de palabras de moda”. Aun así, Ceder dice que incluso si la IA no pudiera hacer la parte más creativa del trabajo en un futuro próximo, aún podría automatizar muchos de los aspectos más repetitivos de la investigación. “En el nivel bajo, estás tratando de analizar qué es algo, cómo responde algo. Esa no es la parte creativa de la ciencia, pero es el 90% de lo que hacemos”. Lu dice que también recibió una respuesta similar de muchos otros investigadores. “La gente dice: tengo 100 ideas para las que no tengo tiempo. Haz que el científico de IA las haga”.

Lu dice que para ampliar las capacidades de los científicos de IA (incluso a campos abstractos más allá del aprendizaje automático, como las matemáticas puras) podría ser necesario incluir otras técnicas más allá de los modelos de lenguaje. Los resultados recientes sobre la resolución de problemas matemáticos de Google Deep Mind, por ejemplo, han demostrado el poder de combinar los LLM con técnicas de IA “simbólica», que construyen reglas lógicas en un sistema en lugar de depender simplemente de que aprenda de patrones estadísticos en los datos. Pero la iteración actual es solo un comienzo, dice. «Realmente creemos que este es el GPT-1 de la ciencia de la IA” dice, refiriéndose a un modelo de lenguaje grande temprano de OpenAI en San Francisco, California.

Los resultados alimentan un debate que hoy en día es una de las principales preocupaciones de muchos investigadores, afirma West. “Todos mis colegas de distintas ciencias están intentando averiguar dónde encaja la IA en lo que hacemos. Nos obliga a pensar en qué es la ciencia en el siglo XXI: qué podría ser, qué es y qué no es”, afirma.

Documento: https://doi.org/10.1038/d41586-024-02842-3